오늘 소개할 논문은 ELSEVIER_Expert Systems with Applications 의

Classification of Individual’s discrete emotions reflected in facial micro-expressions using electroencephalogram and facial electromyogram 이다.

논문은 아래의 링크에서 확인할 수 있다.

https://www.sciencedirect.com/science/article/pii/S0957417421014330

Classification of Individual’s discrete emotions reflected in facial microexpressions using electroencephalogram and facial el

Facial microexpressions are defined as brief, subtle, and involuntary movements of facial muscles reflecting genuine emotions that a person tries to c…

www.sciencedirect.com

논문 요약

이 연구는 뇌전도(EEG)와 안면전자기록(fEMG)을 이용한, 얼굴 미세표현에서의 감정 분류를 목표로 하는 연구이다. 이때, 얼굴 미세표현이란 사람이 자신의 감정을 숨기고 억제하려할때 나타나는 표정이다. 즉, 사람이 감추려하는 감정을 얼굴에 드러나는 미세표현으로부터 알아내고자 하는 연구라고 할 수 있다.

사용한 데이터셋

16명의 피험자에 대해 EEG(10개의 채널)와 fEMG(4개의 전극) dataset을 사용했다. EEG는 뇌의 전기적 활동을 나타내는 신호이고, fEMG는 얼굴 근육 섬유의 수축과 이완을 감지할 수 있는 신호이다. Target값은 피험자의 감정으로, 정답 label은 얼굴의 표정 영상 데이터를 이용한 감정분류값이다. 또한, 정답 label의 보조적 수단으로서 피험자에게 Arousal과 Valence 수치를 설문조사하여, 얼굴 표정영상데이터의 감정분류값과 Arousal/Valence값을 비교해 검증 및 조정하였다. (특정 범위 이하이면 제거하는 방식으로)

연구에서 정답값으로 사용된 '얼굴 표정영상데이터의 감정분류값'은 다음과 같이 결정된다. (기존에 있던 프로그램 이용)

먼저 사용자의 얼굴에 랜드마크를 찍으면, 랜드마크 사이의 거리, 모양 등에 따라 사용자의 감정이 다각도로 분류된다.

한 예로 분석된 피험자의 감정상태를 보면, 피험자 1은 Happy한 감정임을 알 수 있다.

Framework

연구는 16명의 피험자에 대해 진행되었고, 특정 감정을 느끼게 하는 영상을 보여주며 EEG 및 fEMG signal 을 수집하였다. 최종적으로는 피험자의 감정을 Sad, Happy, Anger, Disgust, Surprise, Fear 총 6가지로 분류한다.

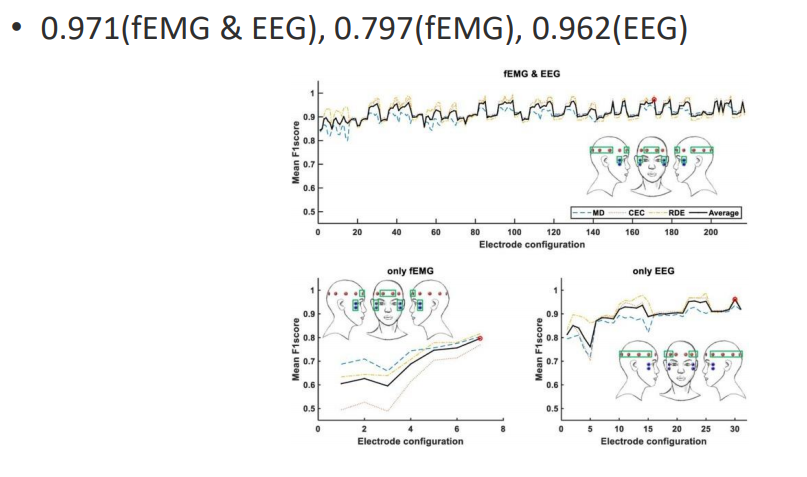

그림과 같이 EEG 및 fEMG signal 에서 Filtering -> Segmentation -> Feature extraction 의 순서로 전처리 및 feature를 추출한다.

Band stop 필터는 신호의 주파수를 통과시키지만, 특정 범위의 주파수를 매우 낮은 수준으로 낮추는 필터이고,

Band pass 필터는 특정 주파수만을 통과시키는 필터이다.

연구에선 58-62 Hz의 주파수를 낮추고, EEG에서 1-50Hz만 통과, fEMG에서 20-450 Hz만 통과 시켰다. 이는 감정분석에 주로 많이 사용되는 주파수 대역대이다.

이후 window마다 높은 비율로 overlap하여 signal을 segmentation한다. (중복되게 자르는 비율이 높다)

마지막으로 EEG에서 Average spectral power, fEMG에서 Root mean square을 추출한다. 이 두 개의 feature를 통해 감정 분류를 하는 것이다.

결국 총 feature는 EEG에서 10 x EEGfeature 개 (10개 채널xEEG의ASP), fEMG에서 4xfEMGfeature(4개 채널xfEMG )개가 된다.

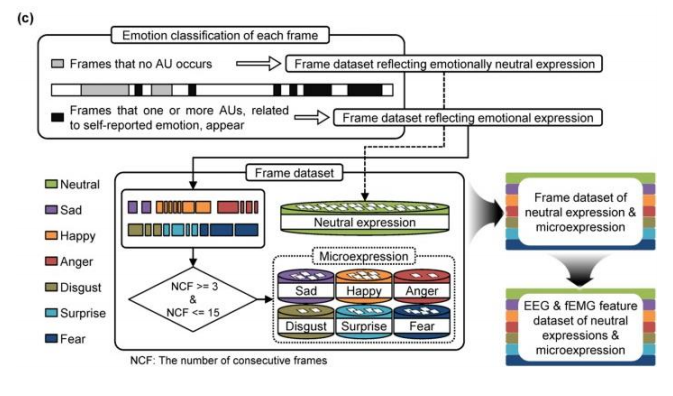

이 과정을 더 자세히 나타내면 다음과 같다.

연구에서는 전체 signal을 이용해 감정분석을 하지 않고,

Frame별로 얼굴 표정(정답값)을 분류해, 감정이 감지되는 Frame의 signal만을 이용해 해당 프레임의 감정을 분류한다.

모델은 SVM 을 사용했다.

연구 결과

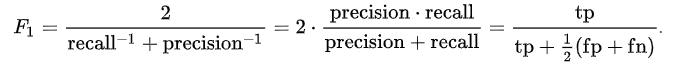

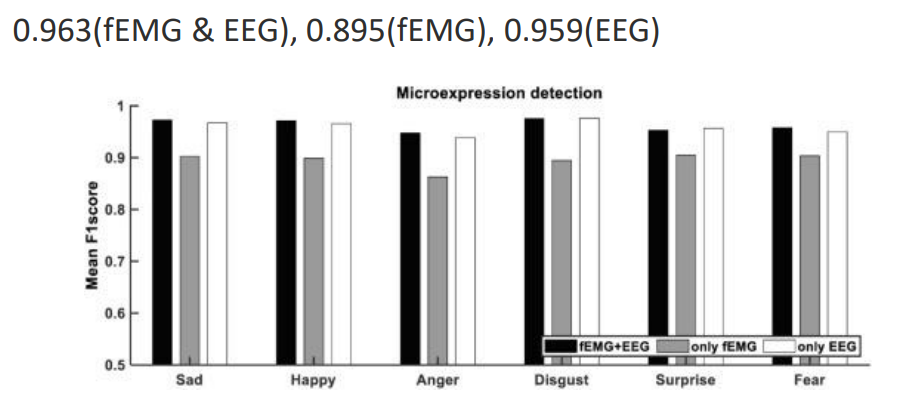

결과는 F1 score를 통해 검증하였다.

* F1 score는 다음과 같이 Precision 과 recall의 조화평균으로 계산된다.

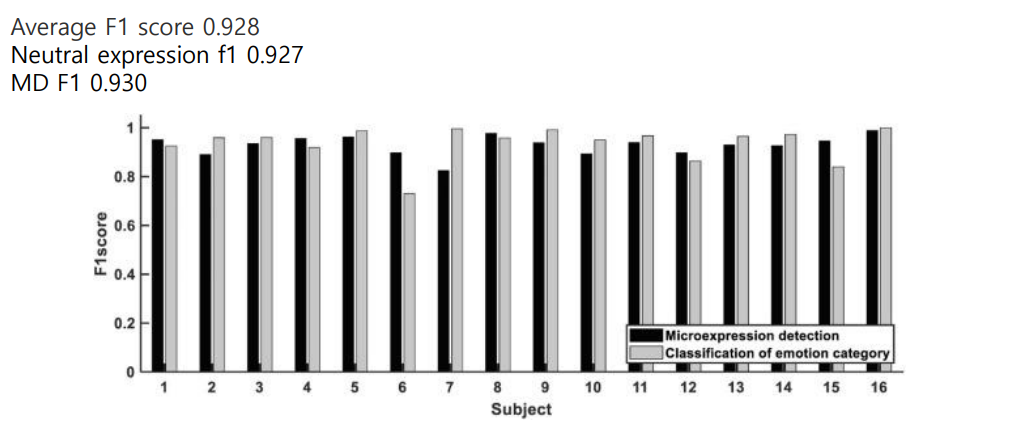

적은 수의 feature를 사용하였음에도 average f1 score = 0.928 로 성능이 매우 좋은것을 확인할 수 있다.

개인적인 의견

전체 signal을 이용해 감정을 분류하지않고, 특정 감정이 드러나는 Frame 에 대한 signal 만 이용해 분석한것이 정확도를 높인 설계라고 생각한다.

개인적으로는 프로그램이 분류한 감정 상태를 정답값으로 두어도 괜찮은가? 하는 의문이 들었다. 이것은 사실 온전한 정답이라기 보다 예측값에 가깝기 때문이다. 연구진도 이 부분을 우려하여, 이를 보완하기 위한 방법으로 설문조사를 통해 수집한 Arousal 과 Valence 수치를 이용한것으로 생각된다.