오늘 읽어본 논문은 Computer science, Human-computer interaction 의

Investigating EEG-Based Functional Connectivity Patterns for Multimodal Emotion Recognition 이다.

논문은 아래의 링크에서 확인할 수 있다.

Investigating EEG-Based Functional Connectivity Patterns for Multimodal Emotion Recognition

Compared with the rich studies on the motor brain-computer interface (BCI), the recently emerging affective BCI presents distinct challenges since the brain functional connectivity networks involving emotion are not well investigated. Previous studies on e

arxiv.org

논문의 특징 요소

• Affective Brain-Computer Interface

• EEG

• Eye movement

• Brain Functional Connectivity Network

• Multimodal Emotion Recognition

Connectivity?

말그대로 각 요소간의 연관성/연결성을 나타내는 지표이다.

논문에서는 functional connectivity 가 사용되었으나, functional connectivity 뿐 아니라 관련한 다양한 Connectivity 기법이 있다.

• Structural Connectivity

• Biophysical connections between neurons or neural elements

• Functional Connectivity <- 논문에서 사용한 것

• Statistical relations between anatomically unconnected cerebral regions

• Effective Connectivity

• Directional causal effects from one neural element to another

논문 요약

EEG의 각 채널간의 Functional connectivity metrics를 계산하여 feature를 도출하고,

Eyetracking data에 대한 feature를 도출해 두 feature를 fusion 하여,

이에 대해 SVM 모델을 통해 다중 분류(5가지)하여 감정을 분석하고자 하는 연구이다.

사용한 데이터셋

피험자에게 특정 감정을 느끼게 하는 동영상을 보여주면서,

64개 채널에서 EEG 신호를 수집하고, 동시에 Eyetracking data를 수집한 것이다. (SEED, DEAP 등)

Framework

1. 먼저 EEG signal data를 주파수 대역대(알파, 델타, 베타, 세타, 감마)로 나누어 4초 간격으로 잘라서, 64x64 의 Dynamic Brain connectivity Metrics 를 형성한다. (connectivity Metrics 란 네트워크 Metrics로, 각 채널을 vertex로 두고 신호와 신호의 상관(연결)관계를 나타내는 Metrics이다.) 이렇게 하면 결과적으로 5 종류의 64x64 Metrics 여러 장을 얻게 된다.

아래의 그림을 참고하자.

2. 1번에서 구한 Metrics 에 대해 Critical subnetwork selection 의 과정을 거친다. 이 과정은 총 3가지를 거치게 되는데, Averaging, Thresholding, Merging 이다.

Averaging 에서는 각 emotion state 별, 그리고 주파수 별로 connectivity metrics의 평균을 낸다. 이렇게 하면 5가지 emotion 에 대해, 그리고 한 emotion당 5가지 주파수에 대해 Metrics 가 할당되게 된다.

이후 Thresholding 을 통해 신호 중에서도 강력하게 나타나는 신호만을 selection 하게되고,

Merging 과정을 통해 주파수대역대로 나눠진 분류를 기준으로, merging 하게 된다.

최종적으로는 각 주파수 대역대로 나뉘어진 64x64의 Metrics 총 5개가 추출되게 된다.

3. 이렇게 추출된 metrics를 Critical connectivity matrices 라고 부른다.

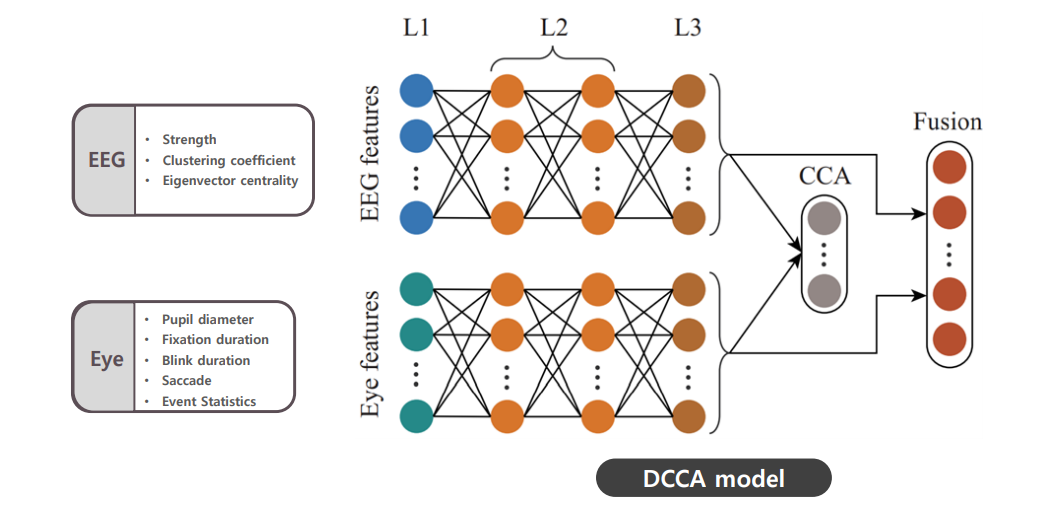

논문에서는 해당 matrics에서 feature를 추출한다. 아래의 그림과 같이 EEG(matrics)에서 3종류, Eyetracking data에서 5종류를 추출한다. 연구진은 이렇게 추출한 EEG, Eyetracking feature를 fusion 하여 최종 feature를 재구성하는데, 이 과정에서 사용한 model을 DCCA라고 부른다.

EEG (64x64 – 주파수별로 5개) feature FROM metrics

• Strength

• Clustering coefficient

• Eigenvector centrality

Eyetracking feature

• Pupil diameter

• Fixation duration

• Blink duration

• Saccade

• Event Statistics

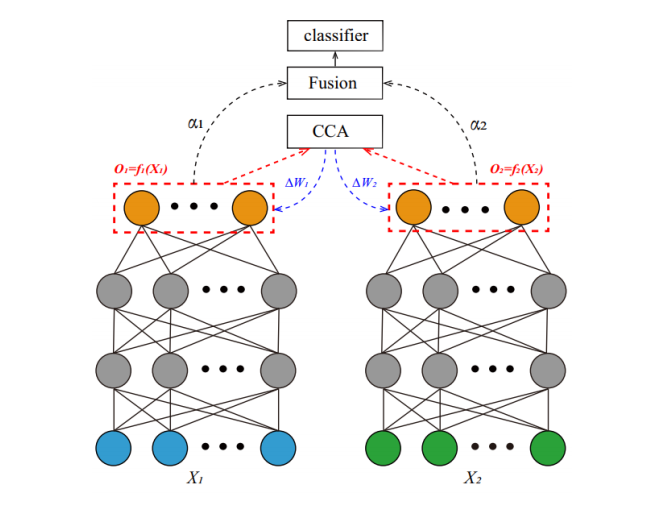

DCCA model(fusion 하는 과정)을 상세하게 나타내면 다음과 같다.

모든 EEG feature와, 모든 Eyetracking feature를 fully-connected 모델에 input으로 넣고, non-linear 형태로 각각 연산한다. (relu 같은 non-linear activation function 을 썼다는 의미라고 생각된다.) 최종적으로 나온 output에 대해, EEG와 Eyetracking data간의 피어슨 상관관계를 계산하고, CCA 를 통해 둘의 상관관계를 최대한 높일 수 있는 방향으로 파라미터를 업데이트 한다. 그리고 최종 결과를 Classifier(SVM)에 넣어 Emotion을 5가지로 classification 한다.

이때 여러가지 feature, 여러 데이터의 상관관계를 한꺼번에 어떻게 구하는것인지 의문이 들 수 있는데

multi-배리얼-statistic- ?? 이라고 하는 기법이 있다고 한다. CCA 뿐 아니라 PLA 등의 기법 또한 있다고 한다.

또, 상관관계를 최대화 하는 방향으로의 파라미터 업데이트를 위한 cost function은 correlation 의 negative 값을 이용해 SVD 계산을 하여 구했다고 한다.

최종 분류 결과

연구진은 다양한 접근으로 정확도를 비교하였다.

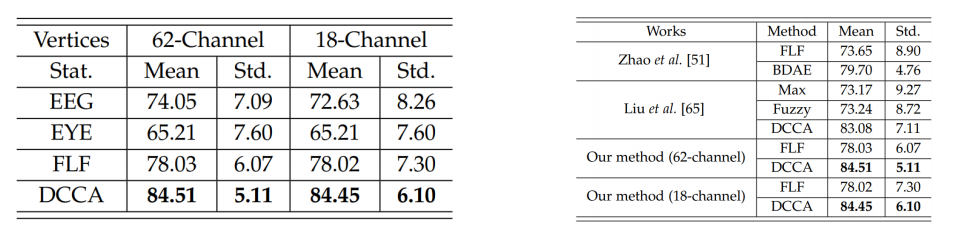

EEG 만 이용해 감정분석, Eyetracking data만 이용해 감정분석, 둘 모두를 합쳐 감정분석(DCCA 모델 제외), 연구에서 제안한 DCCA 모델을 이용해 감정 분석.

이 네 가지의 정확도를 비교한 결과는 다음과 같다.

64채널을 모두 이용하고, 연구진인 제안한 DCCA 모델을 이용한 결과가 가장 높은 정확도를 보이는 것을 확인할 수 있다.